之前的文章介绍了怎么对接DeepSeek的API实现自己的助手,但是依旧使用的DeepSeek官方服务器,在高峰期还是会出现超长延时的情况,本文介绍另一种思路,通过在本机上部署DeepSeek大模型服务来告别卡顿崩溃。

Ollama安装

Ollama是一个运行大模型的服务程序,我们要在自己的电脑上运行DeepSeek大模型的话,需要先安装Ollama,之后通过Ollama来加载对应的模型进行对话。

直接访问Ollama的官方网站,点击页面上的Download按钮进入下载页。

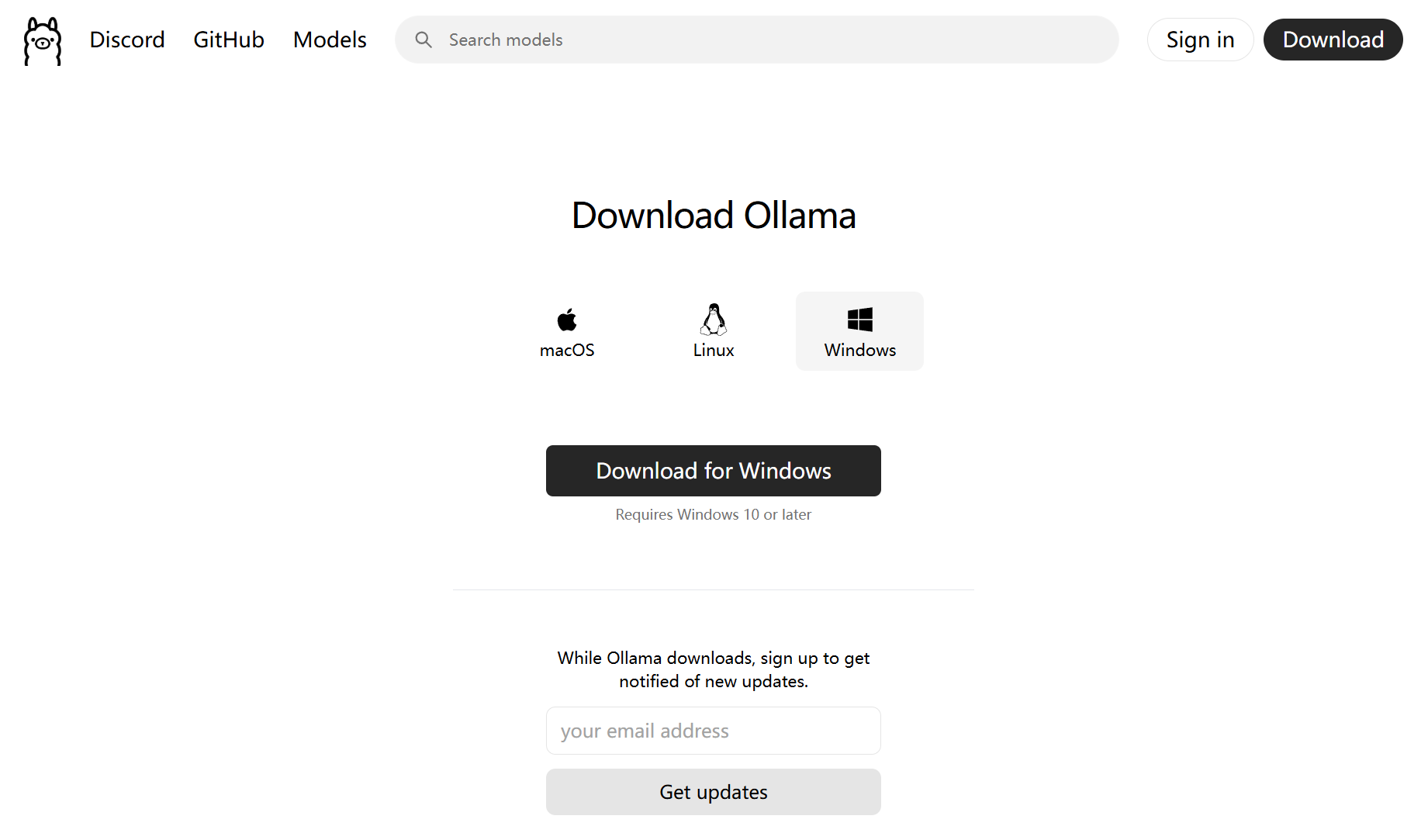

使用的Windows电脑,默认按钮为Download for Windows,点击就可以下载,Ollama还支持在Windows,Linux,macOS上运行。

下载之后直接点击OllamaSetup.exe,即可安装Ollama服务。

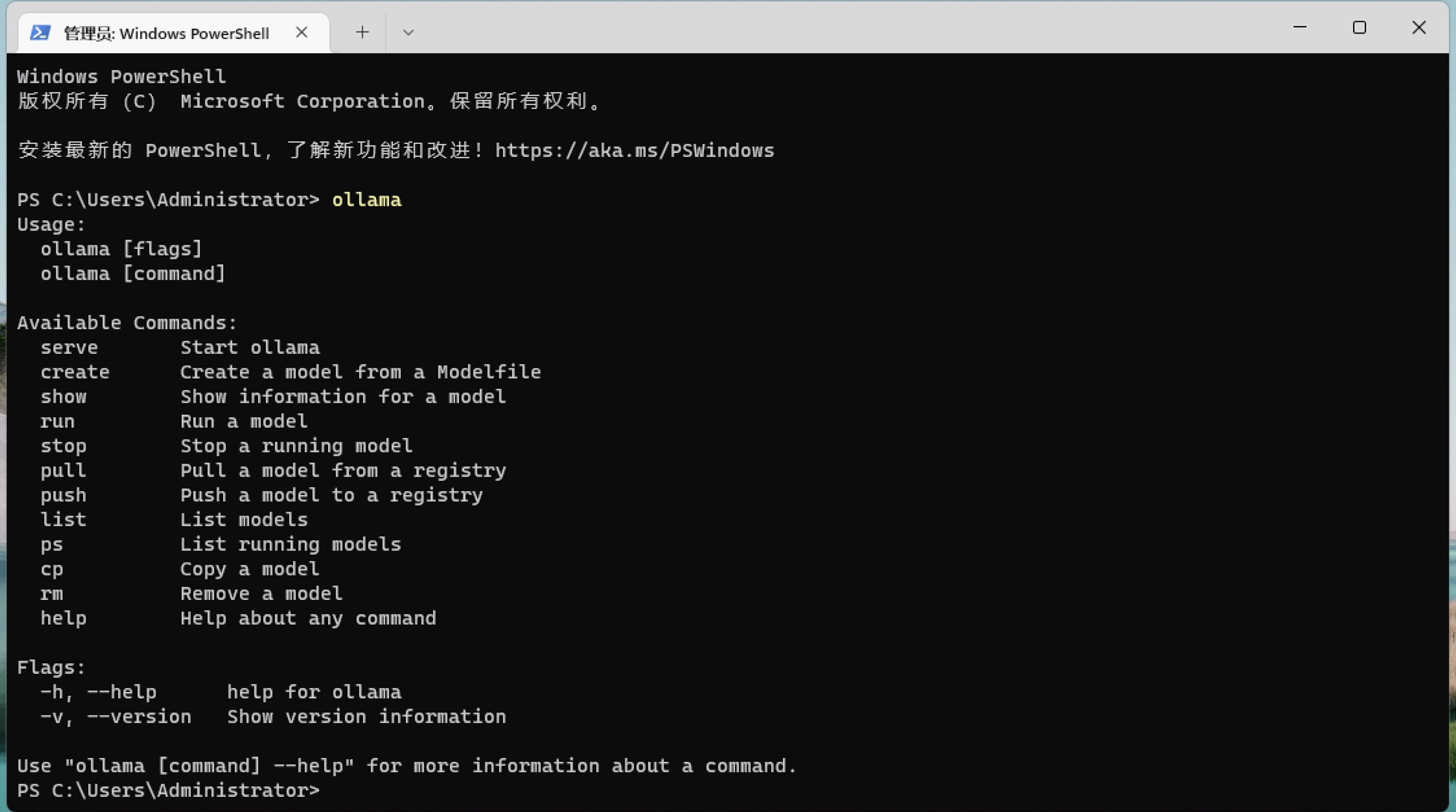

安装之后软件会默认关闭,我们使用控制台(cmd)或者终端来测试安装是否成功。

在控制台中输入ollama,如果出现ollama的参数列表就表示安装成功,还可以输入ollama -v查看安装的ollama版本。

加载大模型

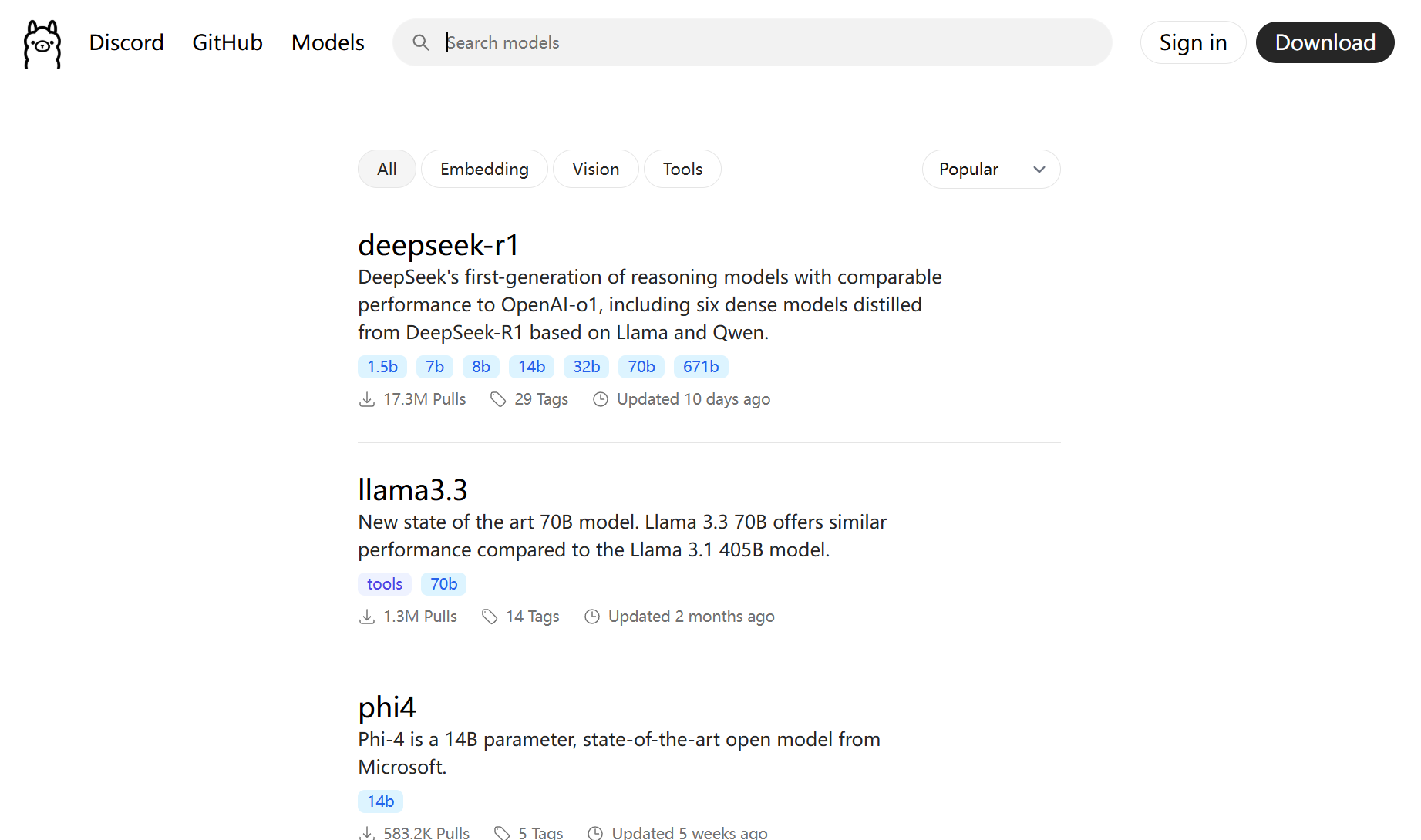

回到ollama的官方网站,点击网站上的Models进入大模型列表页面,首当其冲的就是DeepSeek-r1大模型,

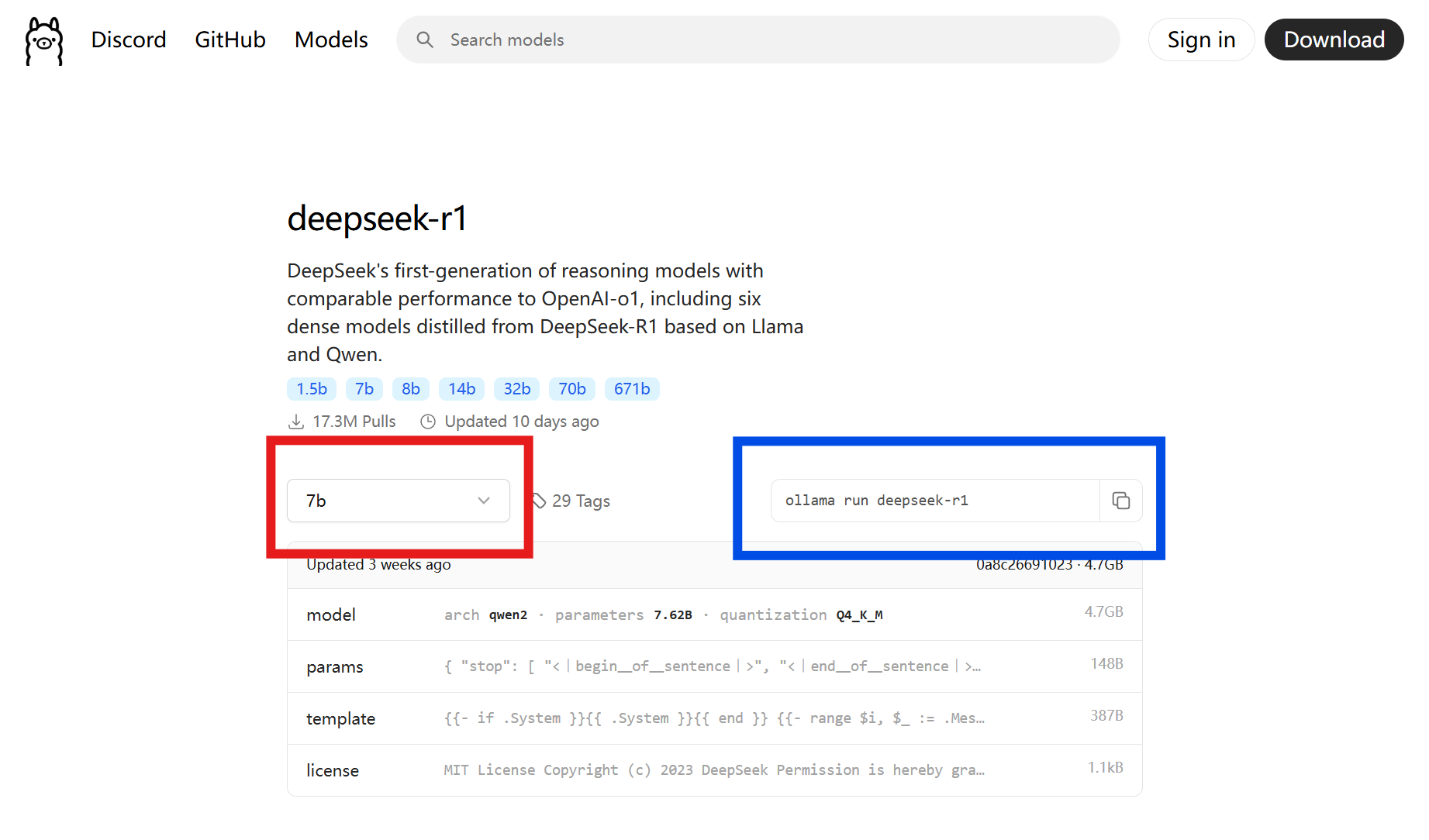

点击deepseek-r1进入到详情页,点击红色框部分可以切换不同参数的大模型,复制蓝色框部分代码到ollama运行就可以加载对应的大模型。

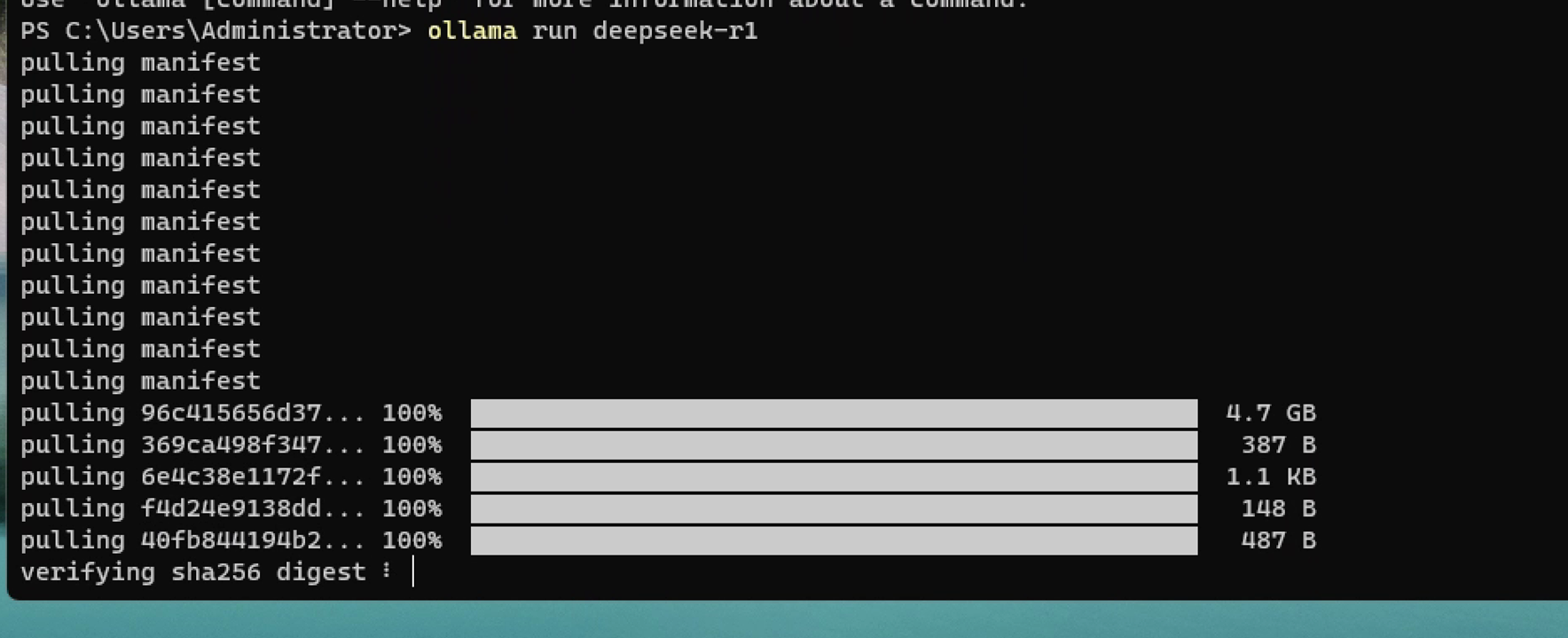

运行对应的大模型代码命令之后,ollama就开始下载大模型文件,下载大模型的过程中也会同步显示进度。如果网络环境不好可能会下载失败,重新运行命令就行。

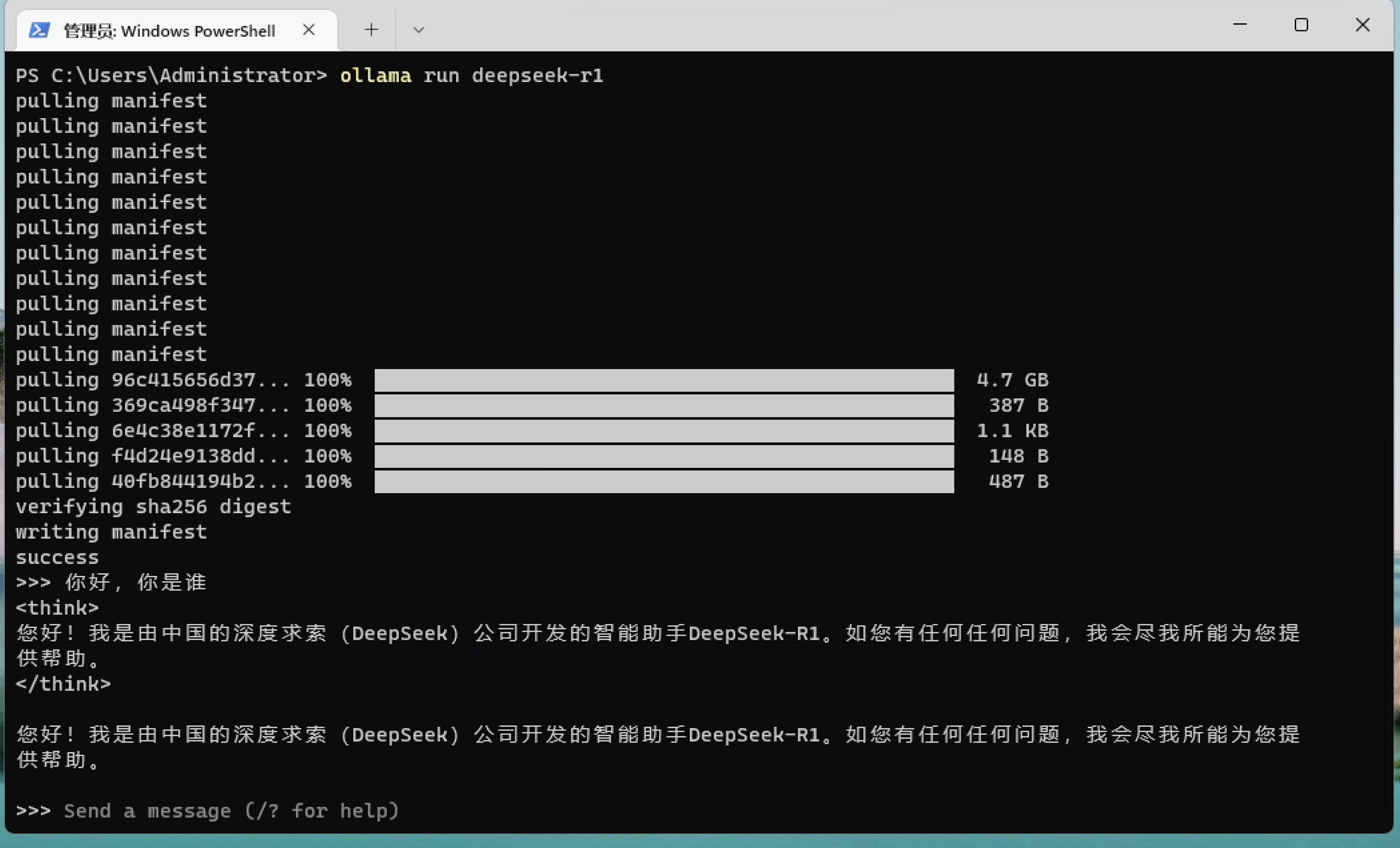

下载完成后会提示success,然后进入到交流部分,这时候我们就可以打字问他问题了

到此我们就在本机完全部署了一个可以本地运行的DeepSeek大模型,如果想要其他参数版本,只要运行对应参数的命令即可。

如果想要接入DeepSeek的API,可以查看:使用C#接入DeepSeek API实现自己的AI助手